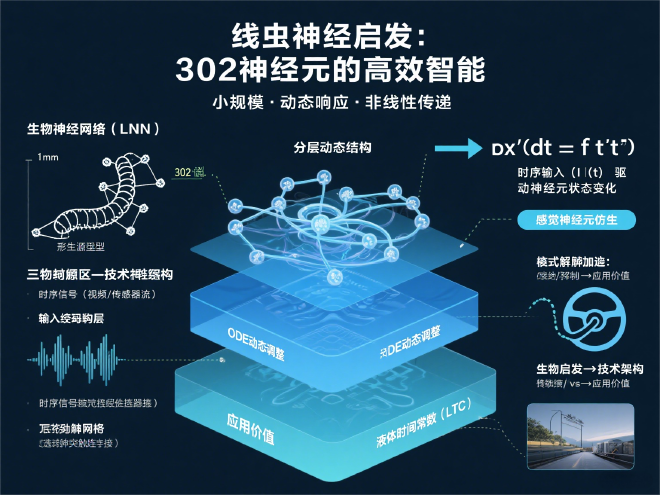

液态神经网络(Liquid Neural Networks, LNN)是一种受生物神经系统启发的动态计算模型,其核心仿生对象是秀丽隐杆线虫(Caenorhabditis elegans)。这种仅1毫米长的线虫虽只有302个神经元,却能完成移动、觅食、学习等复杂行为,且是首个被完整解析神经元连接组的生物。以下从仿生原理、架构设计、技术突破与应用前景展开分析:

一、仿生原理:线虫神经系统的核心启发#

微型结构与高效性

秀丽隐杆线虫的神经系统虽仅有302个神经元,却通过动态电脉冲传递实现环境适应、学习决策等高级行为。这种“小规模高智能”的特性挑战了传统AI依赖大规模参数的模式,推动LNN设计走向轻量化架构(如MIT的自动驾驶模型仅需19个神经元)。动态信息处理机制

线虫神经元通过突触连接的非线性响应适应环境变化。LNN仿照此机制,用常微分方程(ODE)模拟神经元状态:

(\frac{dx(t)}{dt} = f(x(t), I(t), \theta))

其中 (I(t)) 是时序输入,(\theta) 为可调参数。这种设计使网络能根据输入实时调整计算方程,实现“训练后持续学习”。全连接与选择性连接优化

线虫的突触连接具有选择性(非全互联)。当前LNN默认采用全连接,但MIT团队正研究线虫的“布线规则”,以优化神经元连接模式,进一步提升效率。

二、LNN架构的核心创新:流体式自适应#

液体时间常数(LTC)

- 动态时间尺度:每个神经元具备可调时间常数,高频输入触发快速响应(如突发障碍规避),低频输入保留长期依赖(如季节趋势预测)。

- 闭式近似解:2022年MIT发现LTC方程可近似为代数闭式解,避免迭代计算,速度提升数量级(如无人机控制延迟从秒级降至毫秒级)。

分层动态结构

层级 功能 仿生对应 输入编码层 转时序信号(视频/传感器流) 感觉神经元 液态层(核心) ODE动态调整神经元状态 线虫中间神经元网络 输出解码层 生成控制/预测信号 运动神经元 高鲁棒性与可解释性

- 通过微分方程实现“神经路径可视化”,可追溯决策逻辑(如医疗诊断中定位关键时序特征);

- 在噪声环境(如暴雨中的自动驾驶)表现优于传统模型,错误率降低40%。

三、应用与性能:小模型解决大问题#

自动驾驶与无人机导航

MIT实验表明,19神经元的LNN成功控制自动驾驶车辆在曲折道路保持轨迹,采样频率更高;移植至森林无人机后,可适应城市环境突变。跨领域时序预测

在交通流、金融波动等任务中,LNN预测精度超LSTM/Transformer 3-5%,参数量仅传统模型的1/10。脑科学模拟工具

浙江大学“悟空”类脑计算机(2025)利用LNN原理模拟线虫、小鼠等神经系统,为脑研究提供数字化实验平台。

四、与传统神经网络的对比#

下表概括了液态神经网络与传统架构的关键差异:

| 特性 | 液态神经网络 (LNN) | 传统神经网络 (RNN/CNN) |

|---|---|---|

| 时序建模 | ✅ 动态适应非平稳数据 | ⚠️ 依赖固定权重 |

| 计算效率 | ✅ 小模型处理长序列(低功耗) | ❌ 长上下文高显存开销 |

| 可解释性 | ✅ 神经路径可视化 | ❌ 黑盒决策 |

| 持续学习 | ✅ 推理阶段自适应新数据 | ❌ 训练后参数固定 |

| 硬件适配 | ✅ 边缘设备友好(如嵌入式芯片) | ⚠️ 需GPU集群 |

五、挑战与未来方向#

当前局限

- 梯度问题:深层ODE易出现梯度消失,需结合残差连接优化;

- 静态任务弱势:图像分类等非时序任务性能不及CNN。

融合类脑硬件

“悟空”计算机证明,神经拟态芯片(如达尔文3代)可支持千亿突触的LNN部署,功耗仅为2000瓦,较传统AI硬件能效比提升百倍。通用智能路径

通过模拟更复杂生物脑(如猕猴),LNN或推动仿生AGI发展——兼具人脑效率与机器速度。

结语#

液态神经网络从秀丽隐杆线虫中提炼出“小规模、高适应、非线性计算”的精髓,重塑了动态时序数据的处理范式。随着闭式解加速(MIT)与超算平台落地(浙大“悟空”),LNN有望在边缘AI、脑科学、机器人领域开辟低功耗强智能的新疆域。正如研究者所言:“我们从自然获取灵感,终将以计算反哺对自然的理解”。